8 nástrojů pro parsování webových stránek

Rozšíření prohlížeče, cloudové služby a knihovny

Společnost Google poskytuje uživateli relevantní odkazy sledováním sítě a parsováním webových stránek. Parsovací programy se používají nejen k vyhledávání odkazů, které jsou blízké dotazu, ale také ke shromažďování dat.

Tady se dozvíš, jak procházet internet a jaký software budeš potřebovat.

Jak funguje parsování webových stránek

Jedná se o automatický sběr a systematizaci informací pomocí softwaru. Parsery se používají při práci s velkým množstvím informací, které se obtížně třídí ručně. Parsování webových stránek často provádějí vyhledávače. Tento nástroj se používá také k analýze cenové politiky konkurenčních webových stránek a k naplnění jejich online zdrojů. Například sportovní analytické weby se parsují za účelem aktualizace informací o průběhu zápasů nebo sledování komentářů na sociálních sítích.

Platformy, které sledují informace o společnostech, navíc používají parsery pro automatické přidávání nových informací ze státních rejstříků. Možné je také vlastní parsování – vyhledávání chyb na webových stránkách (duplicitní nebo neexistující stránky a také neúplné popisy produktů).

Jak čelit parsování

Můžeš parsovat a následně používat pouze data, která nejsou chráněna autorskými právy nebo jsou k dispozici v otevřených zdrojích. Někdy majitelé stránek instalují ochranu – za velké zatížení serverů se platí a příliš velké parsování může způsobit útok DoS (Denial-of-service).

Způsoby ochrany:

1. Časové zpoždění mezi požadavky (omezuje přístup k informacím pro parser programu)

2. Ochrana proti robotům (nastavení captcha, potvrzení registrace)

3. Omezení přístupových práv

4. Blokování IP adres

5. Honeypot – odkazy na prázdné soubory nebo emulátory serverů sloužící k odhalení hackerů nebo parserů.

Jak obejít ochranu

Hlavní problém s analyzátorem spočívá v tom, že web rozpozná známky atypického chování a zablokuje přístup. Uživatelé neotevírají tisíce stránek během několika minut. Úkolem parseru je tedy vydávat se za běžného uživatele. Jednou z fází je použití vlastních emulátorů nástrojů. Ty odesílají na server požadavky HTTP s záhlavím User Agent, které je stejné jako u běžného uživatele.

Dalším způsobem ochrany je vložení fragmentu JavaScriptu. Úryvek bude úspěšně spuštěn z prohlížeče, ale kód stránky HTML bude při analýze nečitelný. Tento problém řeší platforma node.js, která umožňuje spouštět JS mimo prohlížeč.

Další možností je použití bezhlavého prohlížeče. Jedná se o program, který kopíruje funkce běžného prohlížeče, ale nemá grafické rozhraní. Používá softwarové ovládání a může běžet na pozadí.

Pokud z jedné IP adresy přichází velké množství požadavků, může web vyžadovat ověření pomocí captcha. Některé z nich lze dešifrovat pomocí optického rozpoznávání znaků, ale je lepší změnit IP adresu. K tomuto účelu se používají proxy servery, které požadují informace z různých adres.

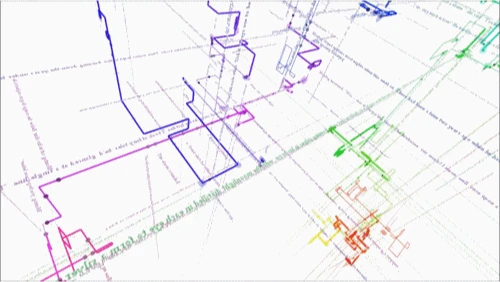

XPath je dotazovací jazyk pro přístup k částem dokumentu XML, který se používá k vyhledávání prvků s určitým atributem. Používá se k implementaci navigace v DOM (Document Object Model), softwarovém rozhraní, které obsahuje informace o struktuře webových stránek, dokumentů HTML a XML.

Software pro parsování

Rozšíření pro prohlížeče

Webové aplikace se používají pro jednoduché úkoly. Každý prohlížeč má taková rozšíření. Jsou vhodné pro analýzu malého množství dat (do několika stránek).

Tento nástroj slouží k extrakci dat z tabulek nebo informací ze stránky ve formátech XLS, CSV a TSV. Placený přístup přidává nové funkce, například rozhraní API a anonymní IP.

Cena: zdarma pro maximálně 500 stránek.

Rozšíření je určeno k importu dat z webových stránek. Je možné kliknout na prvek stránky a vybrat všechny prvky tohoto typu na webu. Scraper.AI má funkci pravidelného sledování změn na webové stránce. Shromážděné informace se exportují do formátů JSON, CSV a XLSX.

Cena: první 3 měsíce zdarma, balíčky stojí od 49 do 249 USD měsíčně.

Cloudové služby

Ve srovnání s rozšířeními mají tyto programy více funkcí. Práce probíhá v cloudu prostřednictvím webového rozhraní nebo rozhraní API a do počítače se ukládají pouze výsledky.

Tato služba slouží k analýze webových stránek s vysokým stupněm zabezpečení. Její použití vyžaduje programátorské dovednosti. Program opakuje neúspěšné požadavky a sám zpracovává captcha. Aplikace umí také vykreslovat prvky, které vyžadují vykreslování v jazyce Javascript. Scraper API pracuje s jazyky Python, Ruby a PHP.

Cena: 1 tisíc požadavků API zdarma, balíčky stojí od 29 do 249 dolarů měsíčně.

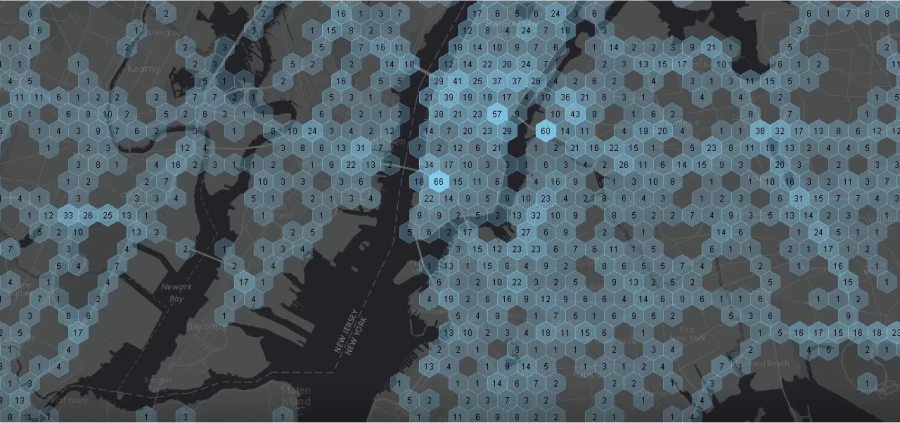

K analýze používá algoritmy ML a počítačové vidění, pracuje s rozhraními API a dokáže automaticky určit typ adresy URL. Diffbot pravidelně prohledává web a ukládá výsledky. Vytváří největší znalostní graf – propojuje fakta o vytvořených produktech, zpravodajských událostech a výsledcích zpráv.

Cena: Prvních 14 dní zdarma, balíčky Start a Plus stojí 299 a 899 dolarů měsíčně.

Desktopové aplikace

Většina desktopových parserů funguje v systému Windows, ale v systému MacOS se dají spouštět z virtuálních počítačů. Existují také multiplatformní řešení. Desktopové parsery mohou být efektivnější než cloudové parsery. Nevýhodou je, že využívají operační výkon počítače.

Aplikace umožňuje integrovat a vizualizovat shromážděná data pomocí systému Tableau BI. Podporuje grafické rozhraní pro zpracování dat typu „ point and click“ (ukaž a klikni). ParseHub má funkci plánovaného sběru datových sad v nastaveném časovém intervalu. Služba funguje v systémech Windows, Mac a Linux. Je k dispozici v cloudové a desktopové verzi.

Cena: Zdarma pro zpracování až 200 stránek, balíčky Standard a Professional stojí 149 a 499 USD měsíčně.

Knihovny pro vytvoření vlastního parseru

Knihovna jazyka Java sloužící k parsování a automatizaci požadavků JSON. Jedná se o formát pro výměnu dat ve webových aplikacích, například pro odesílání informací ze serveru na klienta a jejich zobrazování na webových stránkách. Jaunt funguje jako prohlížeč bez grafického rozhraní, což jej urychluje. Jaunt zpracovává selektivní požadavky a odpovědi HTTP a má také přístup k DOM.

Cena: zdarma

Knihovna s otevřeným zdrojovým kódem pro Python. Používá se pro parsování. Zvláštní vlastností Scrapy je zpracování požadavků asynchronním způsobem: můžete zadat příkaz, aniž bys čekal*a na dokončení předchozího. Také následující požadavky se provedou, i když při zpracování některého z nich dojde k chybě.

V knihovně lze nastavit pauzu mezi požadavky a také regulovat počet požadavků z jedné IP adresy nebo domény.

Cena: zdarma

Je to také knihovna Pythonu, ale jednodušší. Obvykle se používá pro data z dokumentů HTML a XML. Pro otevírání odkazů a ukládání shromážděných výsledků je třeba ke Beautiful Soup připojit další knihovny.

Cena: zdarma

Autor: Alexander Tartachny